SEOを生業にしている以上、避けては通れない(?)手動アクションについての記事です。いわゆる「ペナルティ」と呼ばれる領域ですが、確実に避けるべき事象です。

今回の記事は、元Google社員による記事となり、単純な手動アクションから回復するためのガイド記事ではありません。手動アクションを行う理由や、Webサイトとしてあるべき姿の言及まで、非常に深い内容の記事となっております。

元Googleのクオリティ・アナリストが、Googleのアルゴリズム、手動アクション、品質、ペナルティについて説明する。

サービス開始当初から、GoogleはWeb上で最も求められるインプットボックスという存在になるべく、その道を歩んできた。

この道は、Webのプロフェッショナルからの絶え間ない好奇心と共に監視され、Googleがどのような仕組みであるかを理解するため、その細部に至るまで、分析されている。

Googleが動作しなくなった際は特にであるが、我々は皆、この小さなインプットボックスが生み出すパワーを経験してきている。世界を機能停止に導くパワーを持っているのだ。

しかし、この小さなインプットボックスがWebの世界、ひいては、我々の生活に与える大きな影響を経験するために、Googleの機能停止を体験する必要があるわけではない。

Webサイトを運営し、検索結果を上昇させることができた人には、私が話していることが理解できるだろう。

驚くべきことではないが、Googleが自然検索結果に変更を加えることを決断すると、Webサイトの運営者は皆、固唾をのむことになる。

ソフトフェアのエンジニアリング企業として、Googleは問題の全てを大規模に解決しようとしている。

正直に申し上げると・・・、Googleが解決すべき問題の全てを、人間の介入のみで解決することは、実質的に不可能である。

免責事項:この記事で紹介する内容は、私がGoogleに在籍していた2006年-2011年で得た知識と理解が元になっている。あらゆることが、道理にかなったペースで変化していると仮定すると、私の理解は古い知識である可能性はある。

目次

初心者の方向けに触れておくと、アルゴリズムとはレシピのようなものである。特定のタスクを完遂することや問題を解決することを目的とし、一定の順番で整理された、1つ1つの指示のセットである。

アルゴリズムが期待される結果を生み出す可能性は、完遂することが必要とされるタスクの複雑さに、間接的に比例する。

(期待する結果を生み出したいなら、結果としてアルゴリズムは複雑となる)

そのため、大抵の場合、全ての可能性を扱う単一の巨大なアルゴリズムではなく、解決すべき(巨大で)複雑な問題を単純なサブタスクに落とし込み、複数の(小さな)アルゴリズムを作成するほうが良い。

インプットがある限り、アルゴリズムは休みなく動き、プログラムされたものをアウトプットする。その動作範囲は、ストレージ、プロセッシングパワー、メモリーなどの利用可能なリソースによる。

これらはクオリティ・アルゴリズムであり、インフラストラクチャーの一部ではないことが多い。

もちろん、コンテンツがどのようにクロールされ、格納されるかなどを判断する、インフラストラクチャー・アルゴリズムも存在する。

多くの検索エンジンは、検索結果を提供する段階でのみクオリティ・アルゴリズムを適用する。つまり、検索結果は、提供された時点でのみ、質的に評価されるということだ。

Googleでは、クオリティ・アルゴリズムは、良いコンテンツを再検出し、Googleのインデックス内の品質のシグナルを探すことを目的とした、「フィルター」であると見られている。

これらのシグナルは、多くの場合、Webサイトのページレベルで取得される。

それらのシグナルを組み合わせ、ディレクトリレベルやホストレベルのスコアを算出する。

多くの場合、Webサイトの運営者、SEO担当者、デジタルマーケターはアルゴリズムの影響を「ペナルティ」として認識する。

特に、Webサイトが品質の基準を十分に満たしておらず、Googleが他の品質の高いWebサイトに恩恵を与えた場合は。

こうした場合の多くで、一般的に見られるのが、自然検索におけるパフォーマンスの低下である。

それは、あなたのWebサイトが押し下げられたからではなく、(良くも悪くも)不公平に評価されなくなったという可能性が高い。

こうしたクオリティ・アルゴリズムの仕組みを理解するために、我々はまず、クオリティとは何かを理解する必要がある。

クオリティは見る者の目に宿る。つまり、クオリティとは、我々が生きる世界の中における、相対的な指標であるのだ。

それは、我々の知識、経験、環境に依存するものだ。誰かにとってのクオリティは、他の人がクオリティと考えるものと異なるかもしれない。

クオリティを、脈絡のない単純な2進法のプロセスに結びつけることはできない。例えば、私が砂漠にいてのどが渇いている場合、水筒の中に多少砂が入っていたとしても、全く気にしないだろう。

Webサイトの場合も同様だ。基本的に、クオリティは、期待以上のパフォーマンスとなる。マーケティング用語で言えば、バリュープロポジションとなるだろう。

しかし、クオリティが相対的であるならば、Googleはどのようにして、何がクオリティであるか、何がクオリティではないのかを判断しているのだろうか?

実際、Googleは何がクオリティであり、何がクオリティでないかを判断していない。

ウェブマスター向けガイドラインで使用されている全てのアルゴリズムとドキュメントは、実際のユーザーのフィードバックとデータを元にしている。

ユーザーが検索を行い、Googleのインデックス上でWebサイトと関わりを持つと、Googleはユーザーの行動を分析し、複数のテストを行い、ユーザーの検索意図とニーズに合致しているかを確かめる。

こうすることにより、GoogleがWebサイト向けにガイドラインを発行した際、それらがユーザーの求めるものと一致しているかを確かめることができる。Googleが一方的に求めるものである必要はない。

これは、「アルゴリズムはユーザーを追いかけるために作られている」とGoogleがしばしば言及する理由となる。そのため、あなたがアルゴリズムではなく、ユーザーを追いかければ、Googleが向かう道のりと同じ道のりを歩むことになるのだ。

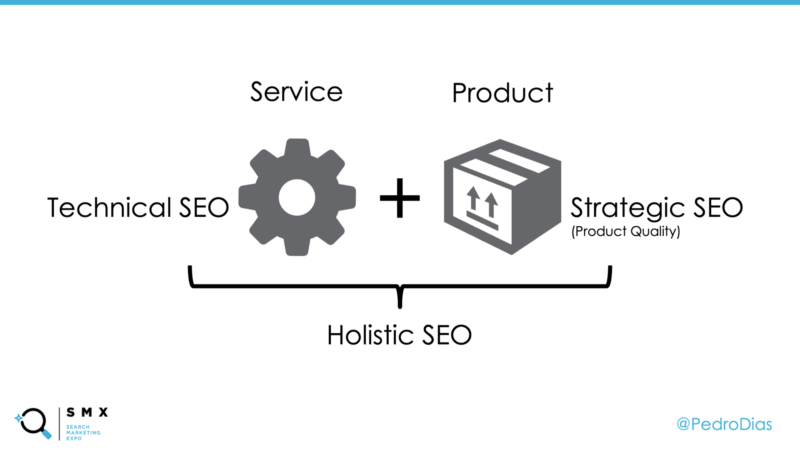

そういったわけで、Webサイトの潜在性を理解し、最大化させるため、我々はWebサイトを2つの側面で見るべきである。1つ目は「サービス」の側面であり、もう1つは、「プロダクト」の側面である。

Webサイトをサービスの側面から見た場合、コードからインフラストラクチャーまで、テクニカルな側面を分析すべきである。

例えば、動作する仕組み、技術的な堅牢性と一貫性、他のサービスと連携するさいの処理方法、全ての要素とフロントエンドのレンダリング、などである。

しかし、技術的な豪華さが、価値の存在しない場所に価値を生み出すことはない。それらは価値を高め、隠れた価値を最高の状態で輝かせる。

そのため、テクニカルな側面に取り組むことも重要だが、Webサイトをプロダクトの側面から見る必要もある。

Webサイトをプロダクトの側面から見る場合、Webサイトにおけるユーザー体験を理解しようとすべきだ。そして、最終的には、競合サイトと差別化を図るために必要な価値を考えることとなる。

これをより具体的なものにするため、私はよくこのように問いかけている。

「本日、あなたのWebサイトがこの世界から消えてしまった場合、競合サイトでは見つけることのできない、あなたのWebサイトの何を悲しむだろうか?」

私はこの質問を、持続可能で長期的なWeb事業戦略を構築する際、最も重要な質問の1つであると考えている。

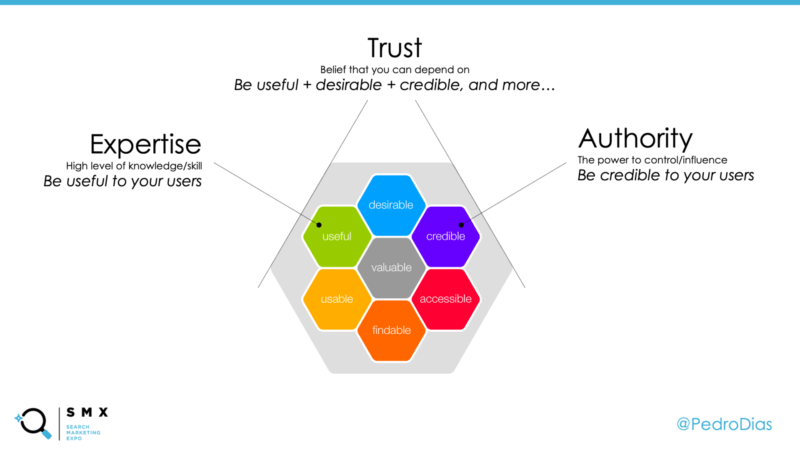

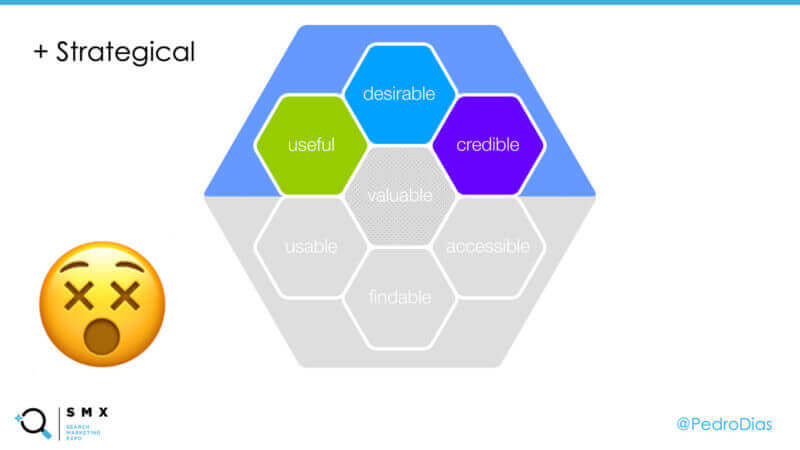

これをさらに深く理解するため、ピーター・モービル氏のUXハニカムを見てみよう。私はこれにいくつかの修正を加えた。Googleの品質ガイドラインにも書かれているE.A.Tの概念により近づくためだ。

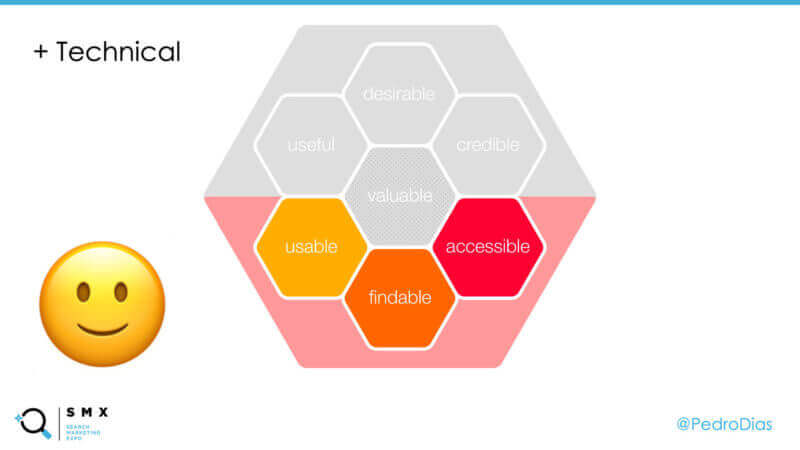

多くのSEOの専門家は、アクセシビリティ、ユーザービリティ、ファインダビリティ(実際に、それらはSEOである)のテクニカルな側面を深く調査する。

しかし、有用性、望ましさ、信頼性のような、質的な(より戦略的な)側面をないがしろにする傾向がある。

念のために言うと、ハニカムの中央は「価値」を表しており、「価値」は他の周囲のすべての要素が満たされて初めて、完全に達成することができる。

そのため、この概念をあなたのWebサイトに適用する場合、全体的な体験を見なければ、核となる目的を見失うことになってしまうだろう。価値を創り出そう!

「高品質である」と見なされるために、Webサイトは価値を提供する必要があり、問題の解決や、ニーズを満たす必要がある。

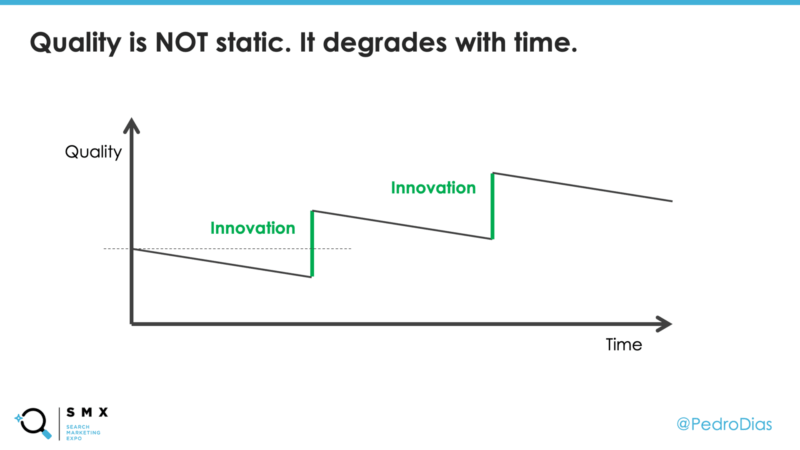

Googleが常にテスト、クオリティアップデート、アルゴリズムの改善を繰り返す理由は、単純に、クオリティは移動する目標であるためである!

Webサイトをローンチし、改善を一度も行わなければ、Webサイトのテクノロジーの改善やユーザー体験とバリュープロポジションへの取り組みなどにより、時間が経つにつれ競合のWebサイトはあなたに追いついてしまう。

古い技術が廃れてしまうのと同様、革新的な体験もやがては普通の体験となり、期待を上回る体験ではなくなってしまうだろう。

例えば、2007年に、Appleはタッチスクリーンのデバイスによって、スマートフォンの市場を席巻した。今日、多くのユーザーは、タッチスクリーンが無ければ電話として見なしてくれないだろう。それはすでにあるものであり、もはや競争における優位性とはならないのである。

同様に、SEOも一度きりの施策とはならない。一度最適化すれば、競合サイトに追いつき、事業を維持するために改善と革新が必要な領域が、恒久的に最適化された状態となり続けるわけではない。

これが成り行きに任されている場合や、これらの特性がユーザーによって理解されるための注意が向けられていない場合、オーガニックのパフォーマンスにおける課題に取り組むべきタイミングと言える。

アルゴリズムは完璧であり、想定されることをつつがなく行うという考えは、甘い考えと言えるだろう。

人間対機械の「戦争」において、人間の大きな優位性とは、我々は想定外の事象にも対応できるという点だ。

人間は、異質の状況に適用し、理解する能力が備わっている。悪く見えるものが実際には良い(逆もまたしかり)理由を理解する能力などだ。

人間は文脈や意図を推測できるが、機械はそれが得意ではない。

ソフトウェアのエンジニアリングでは、アルゴリズムが予期せぬ事態を捕獲、または、見落とした場合、それぞれ、「偽陽性」、「偽陰性」と呼ばれる。

アルゴリズムに訂正を加えるためには、偽陽性と偽陰性のアウトプットを理解する必要がある。それは、人間が行うことがベストであるタスクと言える。

そのため、人間の介入を促す前に、エンジニアは信頼性(閾値)のレベルを設定する。

サーチクオリティの中には、検索結果を評価し、アルゴリズムが適切に動いているかを確認するためにWebサイトを見る人間のチームがある。

また、機械が間違いを犯す場合や、判断ができない場合、介入することもある。

「Search Quality Analyst(サーチ クオリティ アナリスト)」と呼ばれる人たちだ。

サーチクオリティアナリストの役割は、提供されたデータを見ることで、彼らが扱っていることを理解し、判断を下すことだ。

これらの判断はシンプルであるが、他のアナリストによって監査され、承認を得ることもあれば、反対されることもある。先入観を最小化させるためだ。

これは、下記(これらが全てではないが)を目的とした静的なアクションになる場合もある。

これらの静的なアクションは、しばしば、手動アクションとして言及される。

手動アクションの引き金となる理由は多岐にわたる。しかし、何らかの理由により、クオリティ・アルゴリズムの欠陥をうまく悪用した意図的な効果を打ち消すことが、最も一般的な理由だ。

すでに言及した通り、手動アクションの欠点は、静的であり、アルゴリズムのように動的ではないという点だ。

そのため、アルゴリズムが絶え間なく作用し、Webサイト上の変化に対応している一方、手動アクションは再クロールとアルゴリズムの調整に依存してしまうのである。

手動アクションにおいては、設定された期間(日/月/年)、または、再審査リクエストが受理され、正常に処理されるまで、その効力は残り続ける。

ここで、アルゴリズムと手動アクションの簡単な比較を行ってみよう。

あらゆる手動アクションを適用する前に、サーチ クオリティ アナリストは彼らが取り組んでいることへの検討、影響値と理想的な結果の算出を行わなければならない。この場合、確実に応えなければならない質問の例は下記となる。

これらは、どのような手動アクションでさえ、実行されるまえに適切に重みづけされ、十分に考慮されるものである。

検索の改善とスパムの撲滅の両方を目的とし、人工知能と機械学習の優位性を用いながら、Googleがアルゴリズム的な解決を進めるにつれ、手動アクションが適用される機会は少なくなり、最終的には、完全にその姿を無くすだろう。

あなたのWebサイトに手動アクションが適用された場合、まずやるべきことは、どのような行動がその理由となったかを理解することだ。つまり、Googleのテクニカルガイドラインとクオリティガイドラインを理解し、それらに即して、自身のWebサイトを評価するのだ。

情報の全てを同時に処理しようと思ってしまうかもしれない。しかし、ここで焦り、ストレス、不安などを感じる必要はない。速く行うのではなく、徹底して行うことが重要だ。

また、再審査リクエストを送信する機会は最小限に抑えるべきだ。トライ&エラーを行う領域ではない。

全ての情報を集め、Webサイトをきれいにし、あらゆる修正を施す。そして、その全てが完了した場合のみ、再審査リクエストを送付するのだ。

手動アクションを受けトラフィックとランキングが下降しても、手動アクションが解除されれば以前と同様のレベルまで回復する、という誤解がある。これは事実とはかけ離れている。

手動アクションは、不正なレバレッジを抑えることを目的している。

そのため、全ての不正が除去され、手動アクションが解除された後、自然検索のパフォーマンスが同様のレベルまで戻る理屈は無い。

そうで無ければ、品質ガイドライン違反を犯したことから、何も利益を得ていなかったということになるはずだ。

あらゆるWebサイトは、ほぼ全ての状況から回復することが可能だ。回復が不可能と思われる場合は、非常に稀だ。それでも、あなたは、自身が扱っていることを完全に理解すべきだ。

手動アクションとアルゴリズム的な問題が同時発生する可能性があることも覚えておいて欲しい。優先順位をつけ、正しい順番で問題を解決しなければ、何も見えてこないこともある。

そのため、自身のWebサイトが検索においてネガティブな影響を受けたと考えるのであれば、Search Consoleの手動による対策レポートを確認しよう。すべてはそこから始まるのだ。

不幸にも、あらゆるアルゴリズム的な問題の影響と、どこを見るべきかを、簡単に説明する方法は無い。

アルゴリズム的な問題は、蓄積されるだけでなく、タイミングや閾値が異なることもあるため、その多くを目撃し経験しない限り途中で投げ出してしまうこともある。

私が与えることができる最高のアドバイスは、自身のバリュープロポジション、あなたが解決している課題、あなたが提供するニーズについて考える、ということだ。

また、ユーザーからのフィードバックを依頼することも忘れてはならない。あなたの事業とあなたがWebサイトで提供している経験についての意見や、どのような改善を期待しているかなどを尋ねてみよう。正しい質問をすれば、その結果から得られる成果も大きいだろう。

自身のバリュープロポジションと競合優位性を再度考えよう。ドットコムブームの時代はすでに過ぎた。Webサイトを保持することだけでは、競合優位性とはならないのだ。

自身のWebサイトをプロダクトとして扱い常に革新していく。前に進まなければ、置いていかれてしまう。成功するWebサイトは常に改善と反復を行っている。

ユーザー体験を通じて、ユーザーのニーズを調査する。優先度はユーザーが最上位であり、Googleはその次だ。このように考えなければ、見失ってしまう可能性が高まるだろう。ユーザーに話しかけ、彼らの意見を聞こう。

テクニカルSEOは重要だが、それ単独であらゆる問題を解決するわけではない。

自身の製品やコンテンツの訴求力が弱く、価値が低いのであれば、テクニカルな側面が問題で、最適化が必要というわけではないだろう。バリュープロポジションを常に意識することが重要だ。

Webサイトをサービス側とプロダクト側から見るという意見には、非常に賛同いたします。

テクニカルな側面に意識が向きがちになることは多いですが、技術的に優れていることが価値となるかどうかは、別の話となります(もちろん、素晴らしいユーザー体験を提供する技術などはありますが)。

ユーザーにとっていかに価値のあるWebサイトとなるか、手動アクションを避ける目的だけではなく、常に意識しておきたいものです。

SEO最新情報やセミナー開催のお知らせなど、お役立ち情報を無料でお届けします。