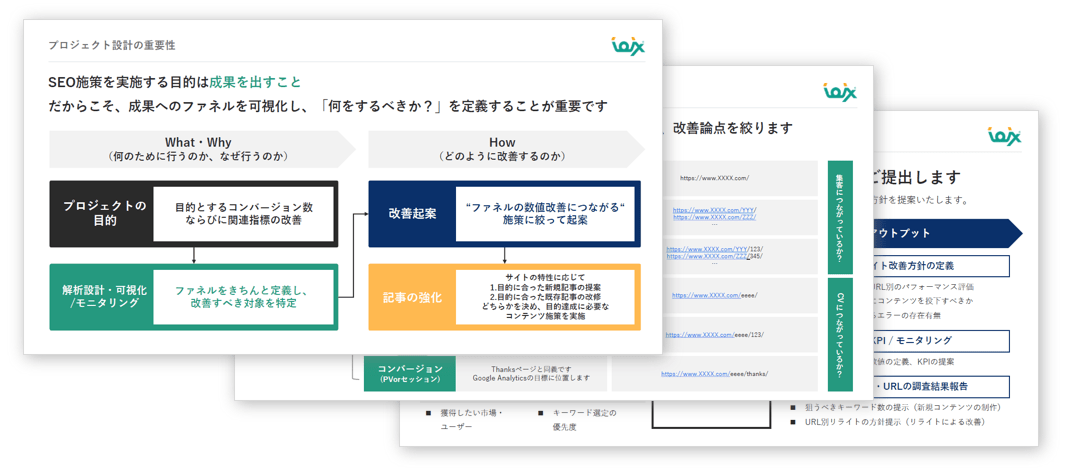

SEOコンサルティングサービスのご案内

専門のコンサルタントが貴社サイトのご要望・課題整理から施策の立案を行い、検索エンジンからの流入数向上を支援いたします。

無料ダウンロードする >>

無料ダウンロードする >>

自然言語処理の方法の一つにWord2Vecがあります。Word2Vecは単語を数値ベクトルに変換して抽出する表現手法で、機械学習・深層学習で用いられる方法として有名です。しかし、Word2Vecの仕組みを把握するには、「ベクトル」「CBOW(Continuous Bag of Words)」「Skip-gram」など初めて学ぶ人にとって難しい概念を理解する必要があります。この記事では、Word2Vecの概要や仕組みについて、初心者にも分かりやすく解説します。

参考:SEOとは? 企業が実施するSEOの目的・内容とメリット・デメリット

目次

Word2Vec(Word to Vector)は、自然言語処理の分野で使われる単語の表現手法の一つです。アルゴリズムはニューラルネットワークに基づいており、「CBOW (Continuous Bag of Words)」と「Skip-gram」の2つの異なるモデルがあります。この2つについては、Word2Vecの仕組みの見出しで詳しく解説します。

Word2Vecは、単語を数値ベクトルに変換する手法です。数値ベクトルとは単語をコンピュータが理解しやすい形式に変換するためのプロセスを意味します。数値ベクトルのメリットは、単語の意味を数学的に捉え、類似度の計算や計算効率を向上させることです。自然言語処理の基本的な手法として広く利用されています。

Word2Vecの特徴として、数値ベクトルのメリットと同様に単語の意味を捉えられる、類似度の計算、計算効率の向上が期待できます。また、Word2Vecの学習済みモデルは転移学習に有用で、少量のデータでも他のタスクに適用できるため、リソースが限られている状況でも効果的です。

単語を数値やベクトルに変換する手法はほかにもあります。具体的には、ワンホットエンコーディング(One-Hot Encoding)とTF-IDFの2つの例が挙げられます。

ワンホットエンコーディング(One-Hot Encoding)は、カテゴリカルデータを数値ベクトルに変換する方法です。Word2Vecは密なベクトルを用いることに対し、ワンホットエンコーディングは比較的雑なベクトルを使用します。各カテゴリは固有の整数に割り当てられ、それに対応する次元だけが1で、他は0のベクトルで表現されます。

TF-IDF(Term Frequency-Inverse Document Frequency)は、文書中の単語の重要度を数値化して評価する手法です。名前の通り「TF」「IDF」の2つの要素に分かれます。

Word2Vecは、単語の周囲に存在する単語や文脈を考慮した意味的な表現を学習します。一方でTF-IDFのようなカウントベースの手法は、単語の出現回数や文書内での頻度を利用します。

TF-IDFの基礎をマスター!キーワード分析の新しいアプローチ方法を解説

Word2Vecの仕組みとして、まず「CBOW (Continuous Bag of Words)」と「Skip-gram」2つのモデルを理解する必要があります。これらは単語の分散表現を学習するためのアーキテクチャであり、単語の予測を目的としています。

CBOWモデルでは、周囲の単語の文脈をもとに対象となる単語を予測します。学習の流れは以下の通りです。

CBOWモデルでは文脈単語から中央の単語を予測することで、単語の分散表現を効果的に学習します。このモデルのメリットは、文脈の周りにある単語の情報を統合することで、文脈による単語の意味や使い方の違いをより正確に捉えられることです。

Skip-gramモデルは、対象となる単語から周囲の単語を予測します。Skip-gramもCBOWと同様に、大きなテキストコーパスから学習対象の単語とその周囲の単語の組み合わせを抽出する仕組みです。学習の流れは以下の通りです。

Skip-gramは類似性の高い単語の関連性をキャッチするのに優れていますが、CBOWよりも学習のボリュームが大きく時間がかかります。

ここでは、Word2Vecを理解するために必要な基本的な単語を説明します。

Word2Vecなどの自然言語処理や機械学習の文脈で頻繁に使用される概念で、簡単にいうと数学的な量を表現するための数の組み合わせです。分散表現の一例であり、単語の意味を複数の次元に分散して表現する手法です。この手法により単語の意味的な関係性を捉えやすくなります。

自然言語処理(NLP)はコンピュータが人間の言語を理解し、処理するための分野です。具体的な分野にはテキストデータの解析、機械翻訳、文書分類、感情分析、質問応答などが含まれます。よく使用される手法として、機械学習アルゴリズムやディープラーニングモデルがあり、テキストデータからパターンを学習してタスクを遂行します。

ニューラルネットワークは人間の脳の構造に着想を得た機械学習モデルの一種で、とくに深層学習において優れた性能を発揮します。ニューラルネットワークは、多くのニューロンから構成された層を有する構造です。ノードは入力を受け取り、それに対する重み付きの結合を計算し、活性化関数を通して出力を生成します。画像認識、音声認識、自然言語処理など、さまざまなタスクに成功を収めている学習モデルです。

ニューラルネットワークとは?概要や機械学習の基礎、仕組みを詳しく解説

単語の分散表現は、自然言語処理において単語をベクトルで表現する手法で、単語の意味や文脈を捉えるのに役立ちます。従来のワンベクトル表現よりも効果的で、各単語が連続的な実数値の次元上に位置する密なベクトルで表現することが特徴です。自然言語処理の多くのタスクに応用されています。

Word2Vecのメリットは以下が挙げられます。

CBOWとSkip-gramといったWord2Vecのモデルは、文脈を考慮して単語を学習します。CBOWは、与えられた文脈からターゲット単語を予測するモデルです。文脈内の単語の分散表現を捉え、その平均をとって予測を行います。また、Skip-gramは、与えられたターゲット単語から周囲の文脈を予測するモデルです。具体的にはターゲット単語の周囲にどの単語が現れるかを予測します。

Word2Vecでは、Hierarchical SoftmaxやNegative Samplingなどの手法を用いて、計算効率を向上させます。Hierarchical Softmaxは、通常のSoftmax関数の代わりに、ツリー構造を用いて単語の確率を計算する手法で、ツリー構造を用いることで計算量を削減します。

Negative Samplingは、Skip-gramモデルにおいて、正例(実際の文脈単語)以外の単語をサンプリングして学習する手法です。ランダムにサンプリングされたいくつかのネガティブサンプルのみを用いて学習することで、計算コストを抑えられます。

転移学習は、あるタスクで学習されたモデルや特徴を、別のタスクでの学習に利用する手法です。Word2Vecの学習済みベクトルは、一般的な言語理解で豊富な単語の意味の情報を含んでおり、効果的に他のタスクに応用できます。学習済みWord2Vecベクトルを初期値として、他のニューラルネットワークモデルを初期化する転移学習モデルへの組み込みをします。また、似た文脈で使われる単語が近いベクトルになる性質を利用した似た文脈でのタスクへの応用も可能です。

ここでは、Word2Vecモデルでは何を実現できるかを解説します。

Word2Vecモデルは、単語を数値ベクトルに変換することで単語の意味的な特徴を捉えた分散表現を獲得できます。

分散表現とは、自然言語処理や機械学習の分野で単語や文をベクトルで表現する手法です。単語や文の意味を捉えるために、連続的で実数値を持つ多次元のベクトルを使用します。

単語の意味的な類似性の計算は、単語間の意味的な関連性や類似性を数値で評価するプロセスです。この計算は自然言語処理や機械学習のタスクにおいて、単語や文の意味を理解しやすくするために重要です。分散表現を生成する手法としては、Word2VecやGloVeなどがあります。

文脈の理解とは、単語や文が使用される状況や周囲の文脈を把握することです。文脈の理解は、単語埋め込みや言語モデルなどの手法を使用して行われます。

Word2Vecでは各単語やフレーズのニュアンスを理解し、ポジティブとネガティブ両方の意味を把握することが可能です。文章や段落の前後関係を解析し文脈を正確に理解できるため、筆者の感情を読み取る感情分析にも役立てられます。また、文脈全体を理解することで、欠落した単語の文脈における意味の推測できます。これらは文章生成や文脈からの情報抽出において重要な要素です。

Word2VecのSEO活用方法を3つ解説します。

Word2Vecでは検索クエリやコンテンツ内の単語の意味的な関連性を理解できるため、ユーザーが入力したクエリと類似した単語を特定可能です。ユーザーが似たような検索クエリを入力した場合でも、そのクエリ間の意味的な類似性を抽出できます。

Word2Vecは単語の意味的な関連性を捉えるため、特定の単語と関連性が高いキーワードを抽出するのに役立ちます。検索エンジン利用者がよく使う類似した言葉やフレーズを特定し、それをキーワードとして選定可能です。

ほかにも、ユーザーの検索意図を理解するのに役立ちます。特定の単語がどのような文脈で使われているかを把握し、それに基づいてキーワードを抽出します。

Word2Vecは単語の意味的な関連性をベクトルで表現するため、活用することで上位記事のテーマや検索エンジンの理解を深めることが可能です。また、単語ベクトルは単語同士の意味的な関連性を捉えていることを利用したうえで、上位記事の文脈をより正確に理解し、適したキーワードや表現を選択できます。

Word2Vecの学習プロセスでは、通常、Softmax関数を使用して単語の出現確率を計算します。Softmaxはすべての単語に対する確率を計算するため、計算コストが高くなるでしょう。また、単語の計算が多くなるとコンピュータが重すぎて負荷がかかります。そうした負荷を軽減し効率的に計算するために、Hierarchical SoftmaxとNegative Samplingがあります。

Hierarchical Softmaxとは単語をツリー構造で表現し、それに基づいて効率的に確率を計算する手法です。単語を表現するための符号(コード)は、木のどの位置にあるかに基づいて構成されます。木をたどることで対象の単語に到達するまでの計算回数が削減されるため、計算効率が向上します。

Negative Samplingは、正例(実際に共起する単語)とは対照的なネガティブな例(共起しないであろう単語)をいくつかサンプリングし、学習する手法です。この手法により、すべての単語についての学習を行わなくても重要な情報を得られ、計算コストを抑えつつモデルの性能向上が期待できます。

Word2Vecとは機械学習・深層学習での自然言語処理の方法の一つです。CBOW (Continuous Bag of Words)とSkip-gram2つのモデルがあり、Hierarchical SoftmaxやNegative Samplingによって計算能力を向上させています。Word2Vecはさまざまなシーンでの活用を期待されていて、マーケティング領域ではSEOへの活用にも注目が集まっています。自社メディアのインプレッションやSEO対策でお悩みの方はぜひ弊社までお気軽にご連絡ください。

SEO最新情報やセミナー開催のお知らせなど、お役立ち情報を無料でお届けします。