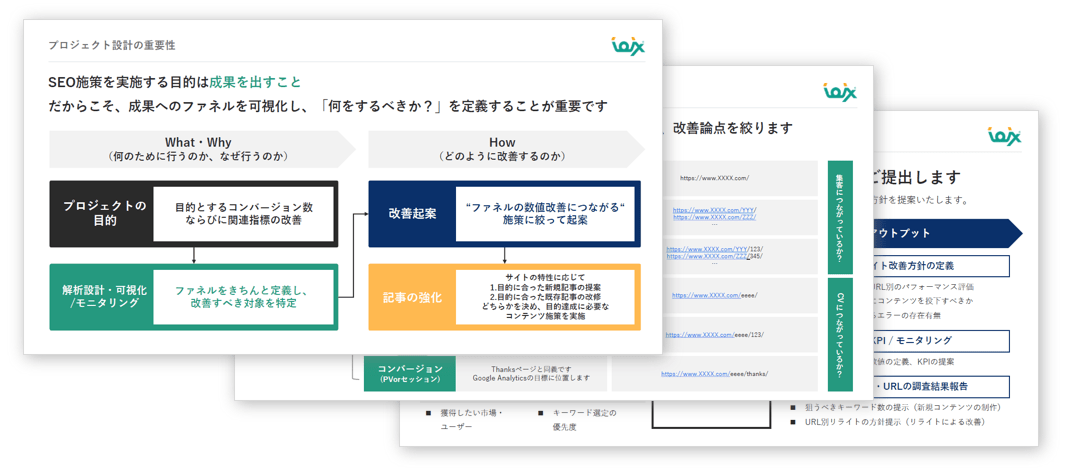

SEOコンサルティングサービスのご案内

専門のコンサルタントが貴社サイトのご要望・課題整理から施策の立案を行い、検索エンジンからの流入数向上を支援いたします。

無料ダウンロードする >>

無料ダウンロードする >>

検索エンジンは、ツイッターやフェイスブックのようなサイトからクロールを始めたほうが良いのだろうか? ウィキペディアやマハロはどうだろうか?DMOZもしくはヤフー!のディレクトリの場合はどうだろうか?

毎日ように新しいページが追加され、古いページは削除されていく。そして、ブログ、新しいサイト、そして、その他のジャンルのページから言葉が溢れだしている。ウェブは猛スピードで更新を繰り返しているのだ。Eコマースのサイトは、新しい製品を展示し、古い製品を消去する。そして、新しいサイトが生まれ、古いドメインの期限が切れていく。

検索エンジンは、ウェブのインデックスを出来るだけ新鮮に保とうと試み、新しいサイト、および更新された変更点を探し、そして、行方不明のサイトを調査するため、クローリングプログラムを送りこむ。 この取り組みをさぼると、検索エンジンは流れについていけなくなり、削除済みのページや上書きされたコンテンツを人々に提供することになる。そして、インデックスは遅れ、新しいサイトを見落としてしまうだろう。

検索エンジンがウェブをクロールする際、選んだシードサイトのURLを追い、その他のページおよびドメインを調査することから始める場合が多い。しかし、検索はこのようなシードサイトをどのように選出するのだろうか?

シードサイトは、各種の話題および地域の広範なサイトにリンクを張り、含めるサイトの選出を自ら行うサイトであり、オープン・ディレクトリ・プロジェクトやヤフー!のディレクトリのようなサイトが当たる可能性がある。

しかし、検索エンジンは必ずしもこのようなサイトを手始めに利用するわけではなく、その他のサイトを選ぶ可能性もある。

シードサイトの選択は、検索エンジンの質、そして、インデックスで異なるトピックと地理的なエリアを網羅する仕組みに大きな影響を与える。 シードサイトの選択が不十分なら、検索結果の質が低くなり、検索結果に表示されるウェブスパムの数は増加の一途をたどるだろう。

検索エンジンがシードサイトとして用いるサイトを選び、ウェブ上のその他のページへのURLを発見する仕組みを解明する特許がヤフー!から申請されている。

ウェブクローラーのホストベースのシード選択アルゴリズム

考案 : パベル・ドミトリエフ

Yahoo!に委託

米国特許申請番号 20100114858

公開 : 2010年5月6日

申請 : 2008年10月27日

要約

ホストの質、重要性、そして、生産力のポテンシャル等の要素を参考にして、ホストの文書をシードとして決めるホストベースのシード選択プロセス。

ホストの重要度、ホストに対する新しい文書の予想される生産力、そして、ホストが所属するマーケットの好みに応じて、多数のホストの一部が特定される。

特定された一部のホストの各ホストに対して最低1つのシードが生成され、少なくとも1つのシードはリンクが張られた文書のデータベース内の文書を示唆する。生成されたシードはデータベースのクローラーがアクセスすることが可能な形式で提供される。

同じシードサイトを定期的に訪問しているだけでは、新しいURLを数多く見つけることは出来ないだろう。そのため、ヤフー!の出願中の特許は、検索エンジンがシードサイトの候補を比べ、選出する仕組みを少し説明している。

この特許によると、特定の選択したシードが以下の場合、シードサイトの選択プロセスが改善されるようだ:

候補のシードサイトが以下の基準によって評価される場合:

潜在的なシードサイトのサイトとしての質(もしくは質の欠落)は以下のようなサイトの特徴によって判断されるだろう:

この特許は、質の高いサイトが、クロールの開始点であるシードサイトの候補として選ばれることが多いと記している。質の低いドメインからクロールを始めると、さらに多くの質の低いページがクロールされることになる可能性が高いためだ。

シードサイトの重要性は“ホストの信頼性”スコアまたは評価、もしくはホストに関連するその他の特徴を基に決められるだろう。ホストの重要性は以下の要素の目安となる:

ページランクは、ホストの信頼性のスコアの一つのタイプと考えられるが、その他の要素も考慮される可能性がある。

ホストにおける文書の潜在的な力、または新しいURLを見つけてもらえるポテンシャルは、ホストに過去のクロールによって集められたスタッツによって計算されるだろう。

マーケットを地理で区別することが出来ると言われているため、多くの新しいURLを生成しようと試みるシードサイトの選択プロセスは、検索エンジンが各国および各地のURLを見つける上で役に立つ地理を基に異なるシードサイトを探している可能性がある。

異なるマーケット(もしくはその他の異なる特徴によっては)のシードサイトに対しては異なる閾値が選ばれる可能性がある。なぜなら、マーケットによっては占有率が低い場合もあり、ホストの数、そして、“重要な”ホストの数が少ない可能性もあるからだ。これは比較的独占的なマーケットがあまりにも強い影響力を持つことを避け、“占有率の低いマーケットではシードサイトがほとんど、もしくは全く選ばれない”事態を回避する効果がある。

私は今まで特許もしくはホワイトペーパーの中で、検索エンジンがクローリングプロセスにおいてシードサイトを選択する際に何を探しているのかに関する詳細な考察を見た覚えがない。

検索エンジンによるウェブのクローリングに関する議論が行われると、ヤフー!ディレクトリやDMZのようなサイトが、ウェブで新しいページをクロールするため、そして、発見するための開始点として例に挙げられる。

そのため、検索エンジンがこのようなディレクトリ以外にシードサイトを特定するために利用する基準を調べる価値があるはずだ。ウィキペディアは良質なシードサイトの条件を備えているだろうか?ツイッターやフェイスブックはどうだろうか?私には断言出来そうもない。

ご存知のように、検索エンジンは、ユーザーにタイムリーな情報を提供している点を感じ取ってもらうため、インデックスにツイッターようなサイトからコンテンツを早く組み込むことに焦点を絞っている。検索エンジンは、このようなサービスのリンクを辿り、シードサイトとして扱い、新しいページや新しいコンテンツを過去のページで見つけているのだろうか?これが正しいとするなら、何を意味するのだろうか?

この記事は、SEO by the Seaに掲載された「What Makes a Good Seed Site for Search Engine Web Crawls?」を翻訳した内容です。

なかなか興味深い記事でした。シードサイトの抽出と選定自体も検索アルゴリズムで行うという考え方が面白いですね。制限なく拡がり続けるウェブにおいて、ジャンル別で起点となるシードサイトを見つけることで、より多くの新規かつ良質の検索結果を返していくことが可能になることは十分想像できます。今後はこういった技術に分面でもあるようにソーシャルネットワークやツイッターがどういう影響を持ってくるのかも興味深いです。 — SEO Japan

SEO最新情報やセミナー開催のお知らせなど、お役立ち情報を無料でお届けします。